Debugging und Fixing mit KI – warum der schwierigste Teil oft bei uns bleibt

Code mit einem KI-Agenten zu schreiben, geht heute unglaublich schnell. Viele Ergebnisse sind auf Anhieb fehlerfrei, und selbst komplexere Funktionen stehen manchmal in Minuten. Trotzdem gibt es einen Bereich, in dem KI für mich noch deutlich schwächelt: Debugging.

Oft schaue ich auf einen Fehler und sehe sofort, was falsch gelaufen ist – manchmal verrät mir die Fehlermeldung schon alles. In solchen Fällen ist es schneller, den Fix selbst einzubauen, anstatt die KI mehrere Versuche machen zu lassen. Gerade bei Layout- oder Template-Anpassungen ist das ähnlich: Ein kleiner Style-Tweak ist meist manuell schneller erledigt, als der KI umständlich zu erklären, was sie tun soll.

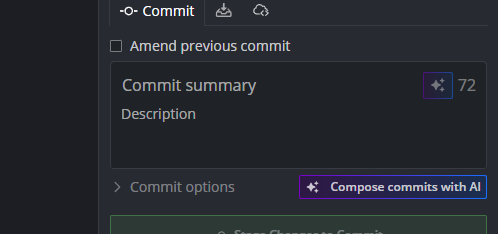

Für die Fehlersuche nutze ich deshalb lieber einen klassischen KI-Chat, statt meinen Code-Agenten weiter herumprobieren zu lassen. Zu oft habe ich erlebt, wie eine KI zwischen zwei Fehlerzuständen pendelt, ohne wirklich weiterzukommen.

Mittlerweile folge ich einer einfachen Regel:

- Wenn ich genau weiß, was falsch ist: Fixe ich es selbst – solange es nur eine kleine Stelle ist.

- Wenn ich die Lösung klar beschreiben kann: Dann darf die KI ran.

- Wenn ich den Fehler erst verstehen muss: Schaue ich erst selbst tiefer rein, bevor ich entscheide.

Ich lasse mir auch lieber ein komplettes Feature von der KI bauen und teste es anschließend Schritt für Schritt, anstatt jeden kleinen Codeschnipsel einzeln durchzugehen. Am zuverlässigsten funktioniert das Ganze, wenn ich vorher sehr klar weiß, was ich will und wie es funktionieren soll. Die KI ist vielleicht nicht die beste Ideengeberin für neue Features – aber sie schreibt Code nun mal viel schneller, als ich es könnte.

Am Ende bleibt für mich: KI ist der Next-Generation Coding Monkey – extrem fleißig, extrem schnell, aber manchmal braucht es doch den Menschen, um Fehler wirklich zu verstehen und zu beheben.

bezahlt von

bezahlt von