Auf Wunsch hier nochmal eine kleine Anleitung wie man Xdebug in einem Docker-Container zusammen mit PHPStorm verwendet. Ich hatte ja schon eine Anleitung für VSCode geschrieben und dort am Ende angemerkt, dass es mit PHPStorm sehr viel einfacher geht. Vorhin nochmal getestet und es geht sehr viel einfacher.

Aber von Anfang an. Wir müssen erstmal das Docker-Image um Xdebug erweitern:

RUN pecl install xdebug-2.8.0 && docker-php-ext-enable xdebug

RUN echo 'zend_extension="/usr/local/lib/php/extensions/no-debug-non-zts-20151012/xdebug.so"' >> /usr/local/etc/php/php.ini

RUN echo 'xdebug.remote_port=9000' >> /usr/local/etc/php/php.ini

RUN echo 'xdebug.remote_enable=1' >> /usr/local/etc/php/php.ini

RUN echo 'xdebug.remote_host=host.docker.internal' >> /usr/local/etc/php/php.ini

Dann installieren wir uns "Xdebug Helper" für den Chrome oder eben die Kombination aus Addon und Browser, die man gerne hätte.

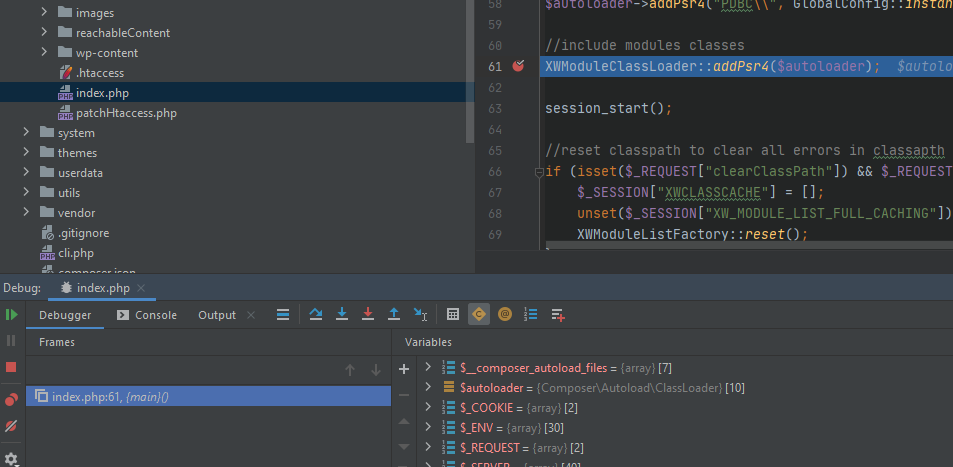

Dann den Docker-Container starten. Die Seite im Chrome aufrufen und dort das Addon aktivieren. Einen Breakpoint in PHPStorm setzen und PHPStorm auf Debug Eingänge horchen lassen.

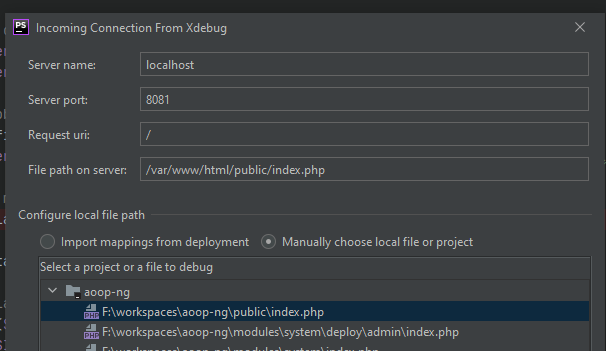

F5 im Webbrowser drücken und dann das Mapping bestätigen.

Das wars. Super einfach und schnell (abgesehen vom Docker-Container bauen) eingerichtet.

Was ist der 31.1. + ein Monat? Den 31.2. gibt es nicht also ist es der 27.2./28.2. oder ein Tag im März?

Von der reinen menschlichen Logik wäre der Xte Tag des Monats der selbe oder der nächstgelegenste mögliche Tag. Aber nie der Tag des nächsten Monats. Wie beim ISO-Kalenderjahr geht man vom Gefühl nicht davon aus dass das neue (Kalender-)Jahr im alten (gefühlten) Jahr anfängt.

/**

* @param DateTime $date

* @param int $months

*

* @return DateTime

* @throws Exception

*/

function addMonths(DateTime $date, $months = 0) {

$firstDayDate = clone $date;

$dayOfMonth = $firstDayDate->format('d');

$firstInterval = new DateInterval('P' . ($dayOfMonth - 1) .'D');

$firstDayDate->sub($firstInterval);

$firstDayDate->add(new DateInterval('P' . $months . 'M'));

$maxDay = $firstDayDate->format('t');

if($dayOfMonth > $maxDay) {

$dayOfMonth = $maxDay;

}

$restoreIntervall = new DateInterval('P' . ($dayOfMonth - 1) . 'D');

$firstDayDate->add($restoreIntervall);

return $firstDayDate;

}

Damit wäre der 31.1. + 3 Monate der 30.4. weil immer im Context eines bestimmten Monats gerechnet wird und dieser Context nicht verlassen werden darf.

Manchmal muss man auch heute noch prüfen ob der Benutzer JavaScript

auf der Seite erlaubt hat oder ob ein Framework wie JQuery korrekt geladen und nicht geblockt wurde.

Prinzip ist einfach. Man versucht die Meldung mit JavaScript nach dem Laden der Seite auszublenden. Wenn es nicht klappt, liegt ein Problem vor und die Meldung ist für den Benutzer sichtbar.

Hier

wird erklärt wie man im Chrome bewußt JavaScript deaktiviert, damit man solche Fälle testen kann.

Eine Notice in HTML

<strong id="">Please activate/allow JavaScript</strong>

Vanilla-JS

setTimeout(function() {

document.getElementById('#noscript-marker').style.display = 'none';

}, 50);

JQuery (prüft auch mit ob JQuery geladen wurde)

setTimeout(function() {

$('#noscript-marker').hide();

}, 50);

Ein kleines Problem, dass mich bestimmt 10 Minuten gekostet hat und nur durch sw:cron:list aufgeklärt werden konnte.

Der CronJob:

Export_orders

wird zu:

Shopware_CronJob_ExportOrders

und muss auch so im Plugin definiert sein.

bezahlt von

bezahlt von